Projets Unreal Engine & UEFN

Découvrez une sélection de mes projets récents et plus anciens développés sous Unreal Engine et UEFN, avec un accent particulier sur les enjeux techniques, les choix d’implémentation et les problématiques propres aux expériences immersives.

Chasse aux risques sur chantier

UEFN

Ce projet est un serious game de chasse aux risques, développé sous la forme d’une map interactive 3D dans Unreal Editor for Fortnite (UEFN). Il vise à sensibiliser à la sécurité de base sur chantier en plaçant les apprenants dans un environnement réaliste où ils peuvent se déplacer librement, observer leur environnement, identifier des situations à risque et s’exercer à distinguer les notions de danger et de risque.

Implémentation technique

Logique de gameplay quasi intégralement développée en Verse

Système de reconnaissance des risques basé sur le champ de vision (FOV) : un risque n’est validé que s’il est effectivement visible par le joueur

Système de scoring personnalisé, adaptable aux objectifs pédagogiques

Pipeline complet d’importation de MetaHumans personnalisés (customisation, vêtements, animations), avec gestion des problèmes d’animation et de compatibilité

Gestion des interactions utilisateur et du feedback visuel

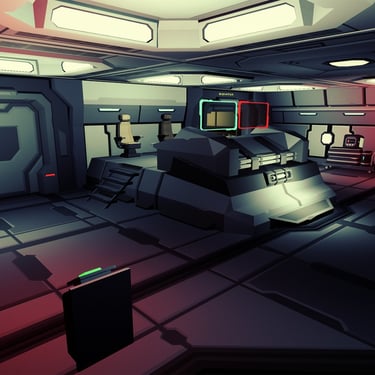

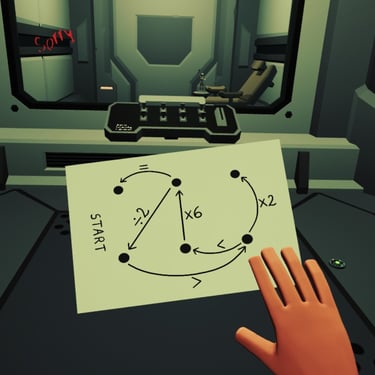

Alone in Outer Space VR

Unreal Engine

A peine après avoir repris conscience dans l’infirmerie du vaisseau spatial OTHRYS ISS, vous constatez que les contre-mesures de sécurités ont été activées. Le vaisseau semble avoir subi une panne générale. Avez-vous ce qu’il faut pour survivre ?

Prouvez vos compétences au travers de trois salles d'évasion uniques (l’infirmerie, le laboratoire et le centre de commandement). Manipulez des objets et recourez à vos capacités de raisonnement pour retrouver le chemin du retour. Vous feriez mieux de vous dépêcher…

Lien : Alone in Outer Space sur Oculus Rift | Jeux VR Rift | Meta Store

Implémentation technique

Développement complet du jeu de A à Z

→ conception, programmation, intégration des assets, tests, optimisation et mise en productionOptimisation VR et performances temps réel

→ gestion du framerate et de la stabilité pour la VR

→ optimisation des assets, des collisions et des effets visuels

→ usage de logs et d’outils de debuggingGestion avancée des déplacements (confort et accessibilité)

→ implémentation de plusieurs modes de locomotionApproche inclusive de l’interaction

→ amélioration de l’accessibilité pour les utilisateurs ayant des contraintes physiques ou de confortIntégration du VR Expansion Plugin

→ gestion robuste des interactions VR

→ manipulation naturelle des objetsGestion de l’audio et de l’ambiance sonore

→ programmation et intégration des sons

→ spatialisation audio pour renforcer l’immersion

→ synchronisation audio / gameplayTravail sur les assets et le rendu visuel

→ modification et adaptation d’assets existants

→ mise en place de post-process pour renforcer l’ambiance et la lisibilité en VR

Avatar conversationnel piloté par l’IA

Unreal Engine

Socrate est un avatar conversationnel piloté par l’IA, capable de dialoguer en temps réel à l’oral et à l’écrit, tout en respectant les connaissances et le contexte historique de l’Antiquité. Développé sous Unreal Engine à partir d’un MetaHuman, il combine IA conversationnelle et synthèse vocale pour créer une interaction crédible et incarnée.

Implémentation technique

Création d’un avatar MetaHuman à partir d’un modèle existant

→ adaptation du visage, cohérence visuelle, gestion des expressions facialesIntégration d’une IA conversationnelle temps réel (Convai)

→ gestion du dialogue, des tours de parole et de la cohérence des réponsesSynthèse vocale et incarnation de la parole (ElevenLabs)

→ génération d’une voix crédible

→ synchronisation voix / animation facialeGestion des interactions utilisateur

→ dialogue à l’oral et à l’écrit

→ déclenchement et enchaînement fluide des échangesIntégration et orchestration dans Unreal Engine

→ communication entre moteur temps réel, IA et systèmes audio

→ maintien de la stabilité et de la fluidité de l’expérience

Tuteur IA contextuel en Réalité Virtuelle Unreal Engine

Ce projet explore le concept d’un tuteur IA en réalité virtuelle, capable de répondre en temps réel à des questions directement liées à ce que l’utilisateur observe dans l’environnement virtuel.

Implémentation technique

Réalité virtuelle immersive avec Full Body

→ gestion du corps entier pour renforcer la présence et l’engagementGestion de l’UI en réalité virtuelle

→ conception et intégration d’interfaces adaptées à la VR (lisibilité, profondeur, ancrage spatial)

→ UI contextuelle déclenchée par l’environnement et les interactions utilisateur

→ équilibre entre immersion et accessibilité de l’informationIntégration du VR Expansion Plugin

→ interactions VR avancées, manipulation naturelle, stabilité du trackingConnexion à l’API OpenAI

→ création d’un assistant IA dédié, limité et contrôléMise en place d’un RAG

→ réponses construites à partir de documents ciblés et contextualisés

Appliquer une procédure d’urgence en VR

Unreal Engine

Ce projet consiste en la création d’un prototype VR permettant de s’entraîner à l’application d’une procédure d’urgence, typiquement un scénario d’incendie. L’expérience place l’utilisateur dans une situation immersive où il doit exécuter une chaîne d’actions précises, dans le bon ordre, pour progresser. Tant qu’une action attendue n’est pas correctement réalisée, il est impossible d’avancer dans la procédure.

L’objectif est de favoriser l’apprentissage par l’action, la mémorisation des gestes et le respect strict des protocoles.

Implémentation technique

Conception d’un système procédural transposable

→ création de chaînes d’événements configurables (actions, conditions, validations)Interactions VR réalistes et robustes

→ prise en compte de la position, de l’orientation et de l’ordre des actionsFocus sur l’extincteur (cas d’usage critique)

→ interaction complète :retirer la goupille

saisir l’embout

orienter l’extincteur

→ impossibilité de déclencher l’action finale sans avoir respecté la procédure correcte

Animations des mains contextuelles

→ adaptation automatique de la posture des mains selon l’étape (tirer, tenir, orienter)

→ renforcement de la crédibilité et de l’immersionSéparation logique / contenu

→ facilité d’intégration dans différents environnements VR

Prototype VR – Photographie de cibles

Unreal Engine

Ce prototype est une première expérimentation en réalité virtuelle, conçue pour s’intégrer facilement dans n’importe quel environnement 3D développé sous Unreal Engine.

Le principe est simple : explorer un environnement, identifier des cibles et les photographier. Ces cibles peuvent être des objets, des personnages ou des éléments spécifiques de la scène.

L’objectif est de transformer des environnements existants en jeux de recherche de cibles, exploitables aussi bien dans des contextes ludiques que pédagogiques, sans nécessiter de modification lourde de l’environnement d’origine.

Implémentation technique

Système de capture d’images en VR

→ génération de screenshots en temps réel depuis la caméra VR

→ sauvegarde des images dans un format exploitable

→ possibilité de rendre les captures téléchargeables ou exportablesReconnaissance et validation des cibles

→ détection d’objets ou d’éléments spécifiques dans le champ de la caméra

→ validation conditionnée à l’angle de vue, à la distance et à la visibilitéIntégration modulaire dans Unreal Engine

→ système pensé pour être réutilisable dans différents environnements 3D

→ séparation claire entre logique de jeu et contenu visuelInteractions VR

→ feedback visuel et sonore lors de la capture et de la validation